Discrete-type Random Variables 1

#ECE313

Random variables and probability mass functions

Definition

离散型随机变量

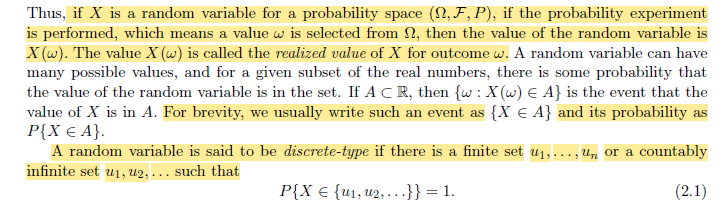

A random variable is a real-valued function on

对于每次实验,我们都可从样本空间中确定一个结果

概率密度函数

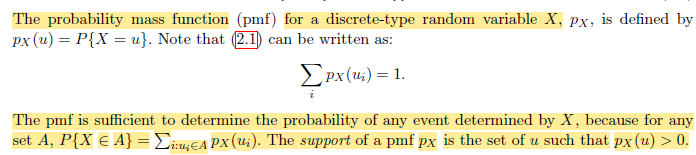

Probability Mass Function

即对应随机变量取值的概率

均值(期望)与方差

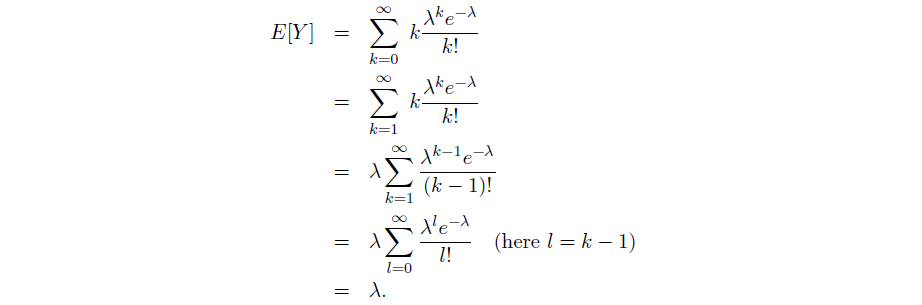

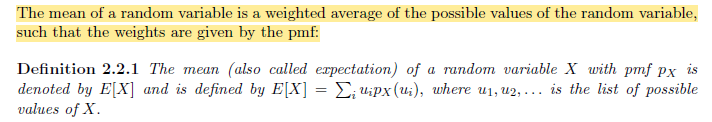

Mean

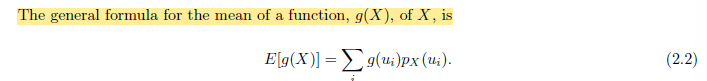

当涉及到与定义的随机变量有关的函数的均值时,我们可以直接取对应的概率求均值 ->Law of the Unconscious Statistication

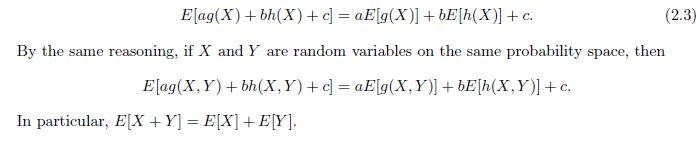

期望的重要性质 ->线性

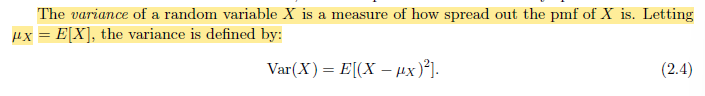

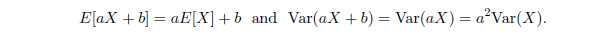

Variance

Standard Deviation:

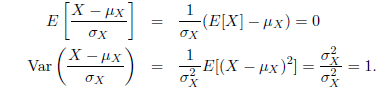

Application: Standardized Version of Random Variable

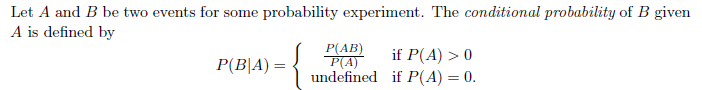

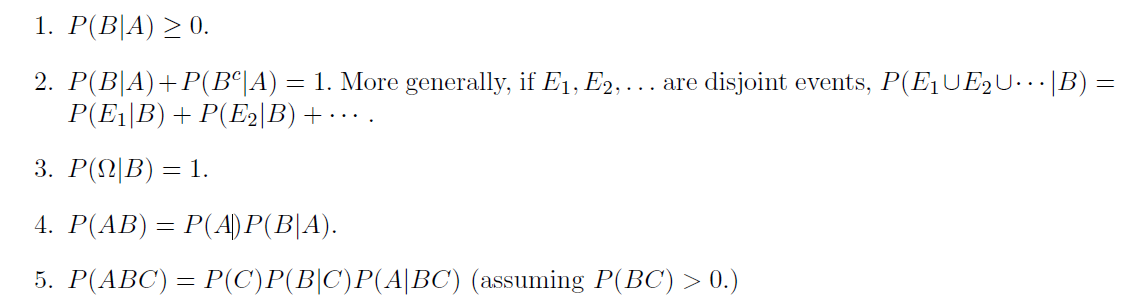

Conditional Probability

Basic

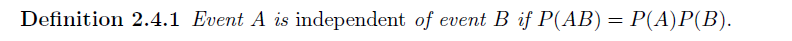

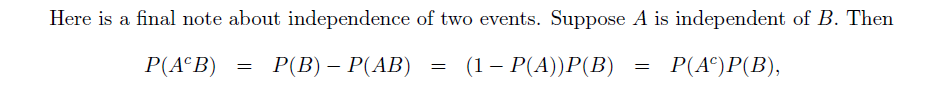

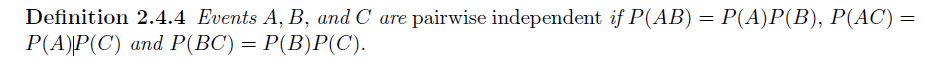

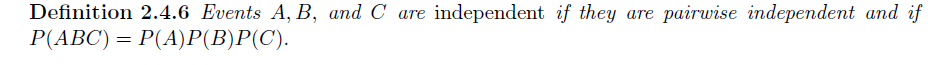

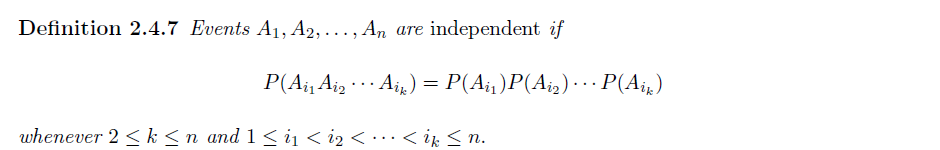

Independence

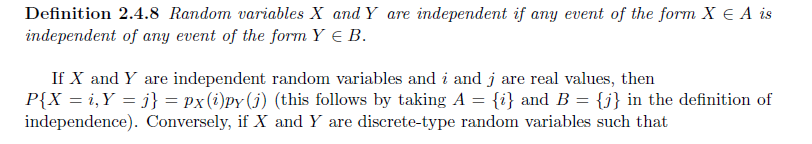

Independent Random Variables

-

Definition

两离散随机变量相互独立当且仅当其所对应所有取值的事件组相互独立

同理,对于多个离散型随机变量相互独立的情况,需要其所对应的所有事件组相互独立

Distribution

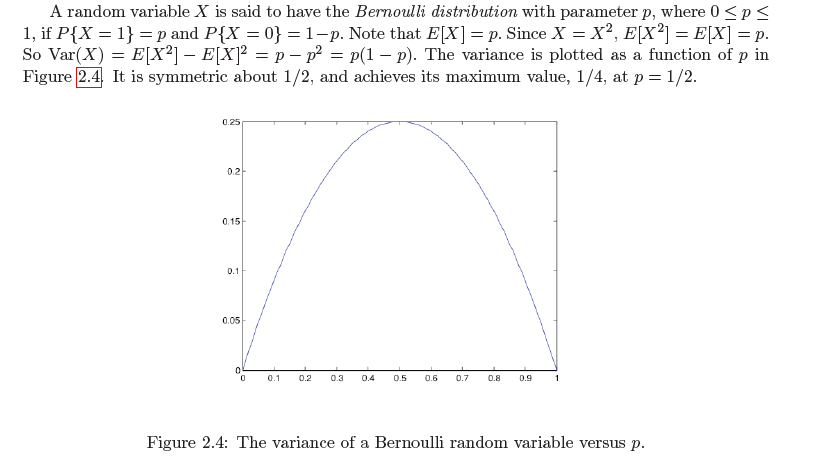

Bernoulli distribution

Definition

伯努利分布即为两点分布,随机变量的取值仅有 0 和 1,1 对应的取值为概率 p

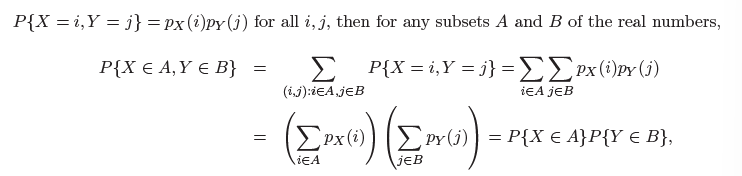

Binomial Distribution

Definition

重复 n 次独立的伯努利实验,以 1 出现的次数作为随机变量的取值

注意到我们有:

最大概率的 k

利用中间项分别大于前项、后项求解

Geometric Distribution

Definition

进行一系列伯努利实验,记

注意 Tail Provability 的便捷计算,直接考虑之前全部失败即可

注意到,我们有:

Mean

考虑差比数列或者母函数

便捷推导:

Variance

便捷推导:

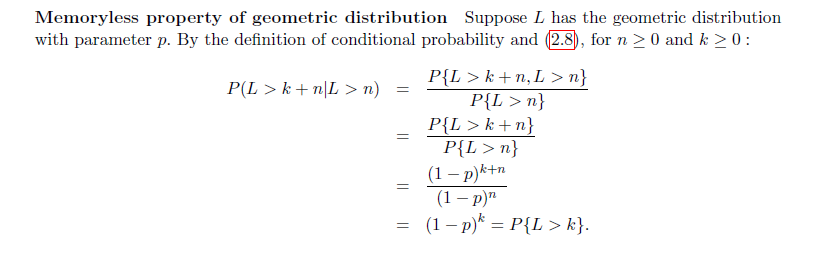

Property

Meaning:

之前进行的实验次数与还要进行的实验次数无关

Interesting Example:2.5.1 将问题进行拆解,类推到作业 3 的第三题,考虑几次结果相互独立 (即为 Negative Bernoulli Distribution)

Bernoulli process and the negative binomial distribution

问题背景:考虑进行无限次伯努利实验,得到一个无穷数列表示每次实验的结果,记为

- Underlying Bernoulli sequence

-

每观察到下一次成功实验所多需要进行的实验次数

-

进行 k 次实验后累计的成功实验的次数

其中

-

得到

基于此,我们将

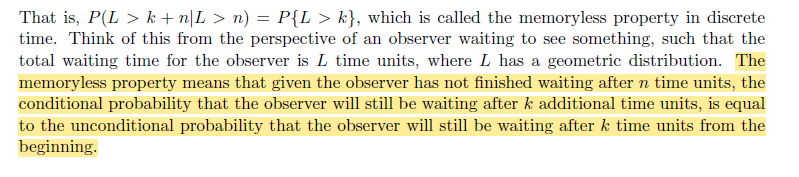

PMF:

Mean:

Variance:

均可以利用母函数推导,类似几何分布(或者通过分解考虑变量之间的独立关系)

对于方差则需要考虑不同随机变量的 Correlation

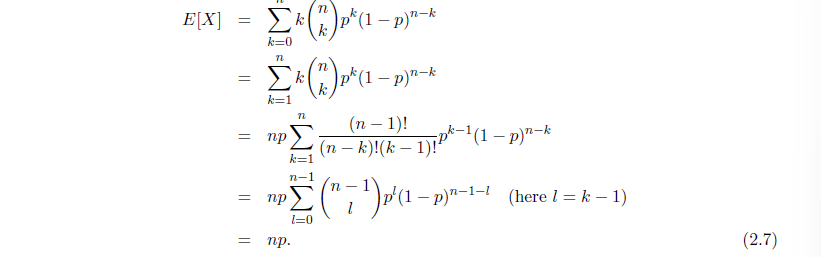

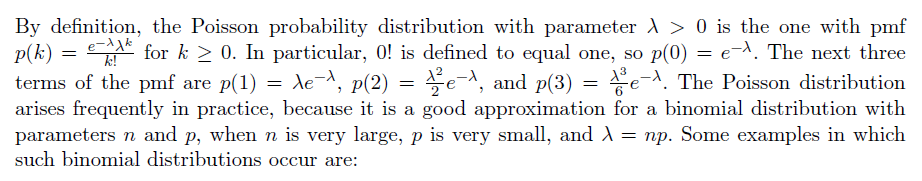

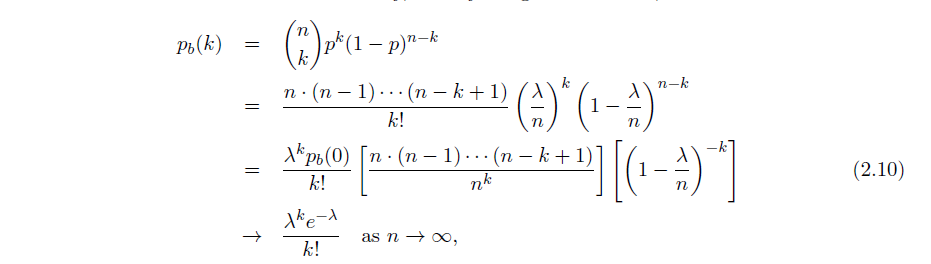

Poisson Distribution - A limit of binomial distribution

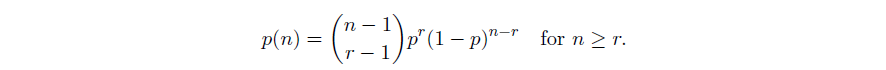

利用泊松分布对于 n 很大 p 很小的二项分布进行近似,以避免计算复杂的二项式系数

近似的原理:

也可对二项分布在